Algorithmen werden zunehmend im Recruiting, im Bildungswesen, bei der Kreditvergabe, in der Medizin oder auch bei der Strafjustiz herangezogen, um die menschliche Entscheidungsfindung zu unterstützen oder in einigen Fällen sogar zu ersetzen. Diese Entwicklung stellt neue Anforderungen an maschinelle Lernverfahren. Ihre Vorhersagefunktionen sollen so gestaltet sein, dass sie für Menschen einfach verständlich sind. Und weil sie Entscheidungen beeinflussen, wären Vorhersagefunktionen, die auch benachteiligten Gruppen zugute kommt (oder sie zumindest nicht noch schlechter stellen), wünschenswert.

Bestimmte Gesellschaftsgruppen sind in quantitativer Hinsicht eindeutig benachteiligt und mit schwierigeren sozioökonomischen Herausforderungen konfrontiert, etwa durch weniger gute Schulabschlüsse und daraus folgend geringerem Einkommen oder Wohnsituationen in Gebieten mit wirtschaftlich schwacher Infrastruktur. Werden Nachteile wie diese wegen eines algorithmischen Ansatzes weiterbestehen – oder sogar verstärkt?

Einfache Algorithmen sind verbesserungswürdig

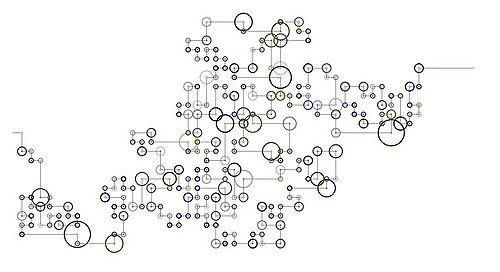

Die beiden Verhaltensökonomen Jon Kleinberg und Sendhil Mullainathan haben ein Modell entwickelt, um das Zusammenspiel zwischen Einfachheit und Gerechtigkeit zu untersuchen. Obwohl diese beiden Konzepte sich von vorneherein durch qualitativ sehr unterschiedliche Ziele auszeichnen, trennt sie eine fundamentale Inkonsistenz, wie das Hauptergebnis zeigt. Einfache Algorithmen sind verbesserungswürdig:

there exists a more complex prediction function that is both strictly more efficient and also strictly more equitable.

Oder anders gesagt: Durch die Verwendung eines zu einfachen Algorithmus wird sowohl der Nutzen für benachteiligte Gruppen als auch das allgemeine Wohlbefinden verringert. Ratsamer wäre also die Verwendung einer komplexeren Funktion.

Dieses Ergebnis betrifft nicht nur Algorithmen, sondern jeden Prozess, der einfache Modelle bildet und damit eine Verbindung zur Psychologie von Stereotypen und einer früheren ökonomischen Literatur über statistische Diskriminierung herstellt.

Sendhil Mullainathan resümiert auf Twitter:

We want algorithms that are simple and interpretable. We want algorithms that are fair. A paper with Jon Kleinberg shows why you probably can’t have both.